权重衰减和L2正则化

发表于|深度学习笔记

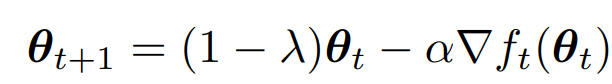

权重衰减是在更新模型的参数时,对当前参数乘以一个系数,公式如下:

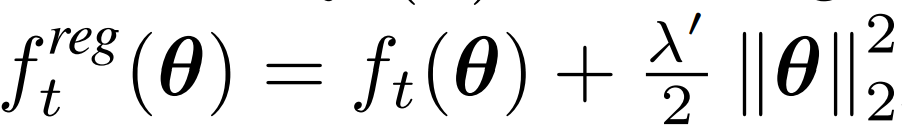

而L2正则化是在损失函数后面加一项约束,如下:

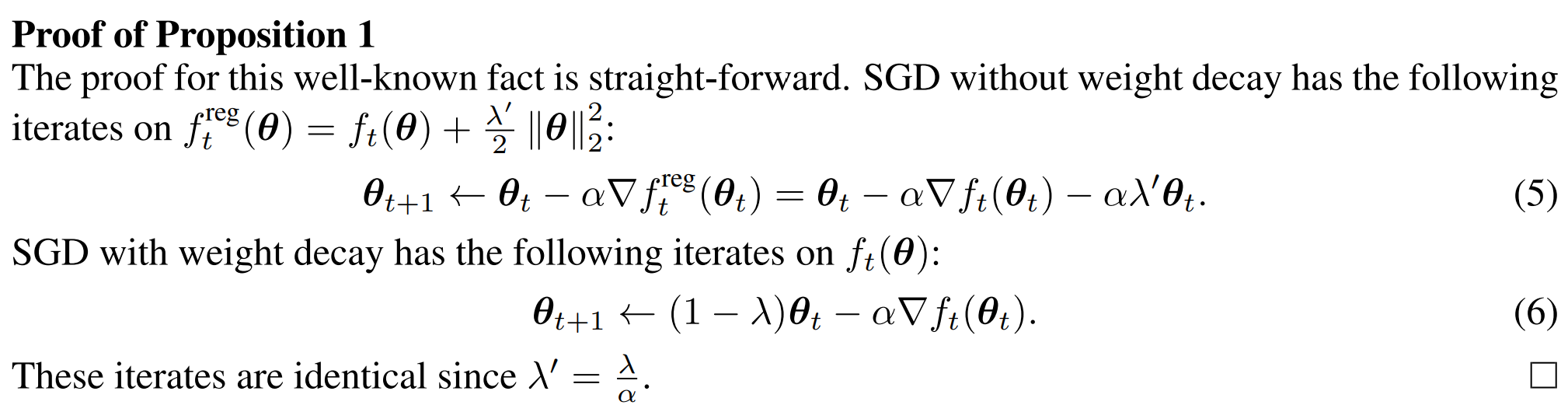

在使用SGD作为优化器,且满足$\lambda’=\frac{\lambda}{\alpha}$时,权重衰减和L2正则化等价,证明如下:

参考:

相关推荐

2021-04-05

1小时快速入门PyTorch

12#二话不说,先把包导入进来~import torch tensor初始化123#定义一个tensormy_tensor=torch.tensor([[1,2,3],[4,5,6]])print(my_tensor) tensor([[1, 2, 3], [4, 5, 6]]) 123#指定tensor的数据类型my_tensor=torch.tensor([[1,2,3],[4,5,6]],dtype=torch.float32)print(my_tensor) tensor([[1., 2., 3.], [4., 5., 6.]]) 123#指定devicemy_tensor=torch.tensor([[1,2,3],[4,5,6]],dtype=torch.float32,device='cuda')print(my_tensor) tensor([[1., 2., 3.], [4., 5., 6.]],...

2021-07-28

FFB6D

FFB6D: A Full Flow Bidirectional Fusion Network for 6D Pose Estimation 来源: CVPR2021代码:https://github.com/ethnhe/FFB6D 提出的问题 RGB图像+CNN:透视投影会导致几何信息损失 RDB-D+CNN::如何有效地充分利用这两种数据模式(RGB图+深度图)来进行更好的6维姿态估计? 已有的方法 使用级联思想,先从RGB中做粗略估计,再使用ICP或多视图的假设检验做后续优化。这种方法并不是端到端的方式,而且非常耗时。 使用两个网络,一个CNN,一个PCN( pointcloud network),分别从RGB图和点云文件中提取特征(croped RGB image and point cloud),然后把这两种特征concat在一起(称之为 dense features),用于姿态估计。这种混合特征的方法(concat)太naive。 也是用两个网络,CNN和PCN,只不过将特征混合方式由concat改为dense fusion,如下图: ...

2021-04-09

FaceFromX

2021-07-30

G2L-Net

G2L-Net: Global to Local Network for Real-time 6D Pose Estimation with Embedding Vector Features 来源:CVPR 2020代码:https://github.com/DC1991/G2L_Net引用量:8新版本:FS-Net(CVPR2021),还没看 提出的问题 一些基于深度学习的方法预测表现达到了sota,但做不到实时性,太慢 虽然存在一些方法能够做到实时性,但这些方法只是用了RGB图,无法处理存在遮挡和光照变化的情况 当加入深度信息后,可以处理诸如遮挡的复杂情况,但是计算密集。并且这些基于RGBD的方法的一个常见问题是:利用来自深度信息中的视点信息(view point infomation)并不是很有效,从而降低了它们的姿态估计精度。为了克服这一点,这些方法倾向于使用后细化机制( post-refinement mechanism)或假设生成/检验机制(hypotheses generation/verification...

2020-10-12

Keras中关于模型的trainable状态的问题

提出问题在看GAN的实现代码的时候,发现了这么一个地方: 123456789101112131415161718192021222324252627282930313233class GAN(): def __init__(self): self.img_rows = 28 self.img_cols = 28 self.channels = 1 self.img_shape = (self.img_rows, self.img_cols, self.channels) self.latent_dim = 100 optimizer = Adam(0.0002, 0.5) # Build and compile the discriminator self.discriminator = self.build_discriminator() ...

2020-08-16

LSTM

可以把 lstm的memory看做一个neural LSTM的解释图: 一个neural的工作过程 有点RNN的味道了 真正的LSTM

公告

本站内容的最终版本将发布在微信公众号[南极Python]